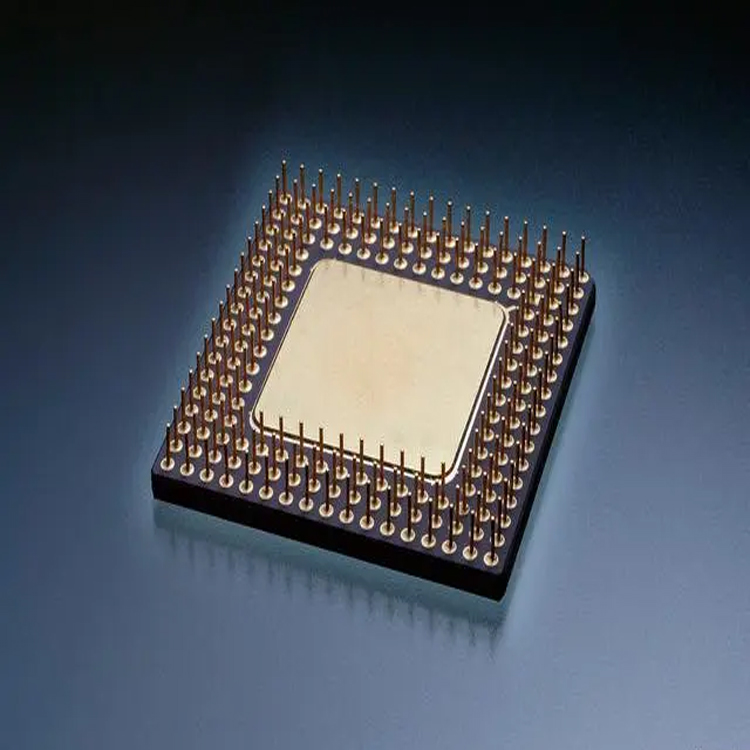

Chip di circuiti integrati (IC):

Definizione: un chip di circuito integrato è un materiale piccolo e sottile a base di silicio che integra componenti elettronici come transistor, resistori, condensatori, ecc. È un componente fondamentale dei dispositivi elettronici.

Processo di produzione: il processo di produzione dei chip prevede l'utilizzo della tecnologia fotolitografica per formare schemi di circuiti su wafer di silicio, quindi la formazione di componenti elettronici attraverso processi come deposizione, incisione e diffusione e infine il confezionamento in un chip completo.

Funzione: il chip viene utilizzato per eseguire funzioni elettroniche specifiche, come un chip microprocessore per l'unità di elaborazione centrale di un computer, un chip di archiviazione per memorizzare dati e un chip sensore per rilevare l'ambiente.

Applicazione: i chip sono ampiamente utilizzati nei dispositivi elettronici, inclusi computer, telefoni cellulari, televisori, sistemi elettronici automobilistici, dispositivi medici e altri campi.

Tipo: in base alle diverse funzioni e scopi, i chip possono essere suddivisi in vari tipi, come microprocessori, chip di archiviazione (RAM, ROM), chip sensore, chip amplificatore, ecc.

Imballaggio: una volta completata la produzione, il chip deve essere imballato inserendolo in un involucro protettivo per evitare danni e migliorare la connettività.

Legge di Moore: con il passare del tempo, la tecnologia di produzione dei chip è stata continuamente sviluppata e la legge di Moore stabilisce che il numero di transistor che possono essere ospitati sui chip dei circuiti integrati raddoppierà ogni 18-24 mesi.

Nel complesso, i chip costituiscono il fondamento della moderna tecnologia elettronica e le loro dimensioni ridotte e l’elevata integrazione rendono i dispositivi elettronici più compatti, efficienti e potenti.